人工智能无处不在。最近新的人工智能技术和工具的爆炸式增长引入了许多你需要知道的新术语来理解它。

这项技术推动了虚拟助手,比如苹果的Siri,帮助医生通过核磁共振成像发现癌症,并让你的手机识别你的脸。

生成内容的工具重新点燃了这个领域。聊天机器人,如ChatGPT和Bard,编写软件代码和章节书。语音工具可以操纵名人的讲话。图像生成器可以制作出超现实的照片,只需要一点文字。

这项突破性的技术有可能彻底改变整个行业,但即使是专家也很难解释一些工具是如何工作的。对于这些进步是会带来乌托邦式的未来,还是会带来难以分辨真实与虚构的危险新现实,科技领袖们意见不一。

什么是人工智能?

人工智能是一系列技术的总称:没有单一的定义,甚至研究人员也不同意。

一般来说,人工智能是计算机科学的一个领域,专注于创造和训练机器来执行智能任务,“如果有人在做这件事,我们会称之为智能,”西北大学计算机科学教授拉里·伯恩鲍姆(Larry Birnbaum)说。

几十年来,人工智能主要用于分析,使人们能够通过评估大量数据来发现模式并做出预测。

但该领域的进步导致了生成式人工智能的蓬勃发展,这是一种可以制造东西的人工智能。这项技术可以创造文字、声音、图像和视频,有时达到模仿人类创造力的复杂程度。它支持聊天机器人,如ChatGPT和图像生成器,如DALL-E。

虽然这项技术不能像人类一样“思考”,但它有时可以创造出类似质量的作品。人工智能图像生成器可以制作出欺骗艺术评委的照片,让他们认为这些照片是人造的,语音生成软件可以保留患有ALS等退行性疾病的人的声音。

由生成式人工智能支持的聊天机器人通过进行令人毛骨悚然的逼真对话而让用户眼花缭乱——这是艾伦·图灵(Alan Turing)设想的该领域的早期梦想。1950年,他开发了“图灵测试”,通过它能在多大程度上欺骗用户,让他们相信它是人类,来判断人工智能机器是否成功。

图灵从来不相信计算机真的能“思考”,他认为这个问题“毫无意义,不值得讨论”。

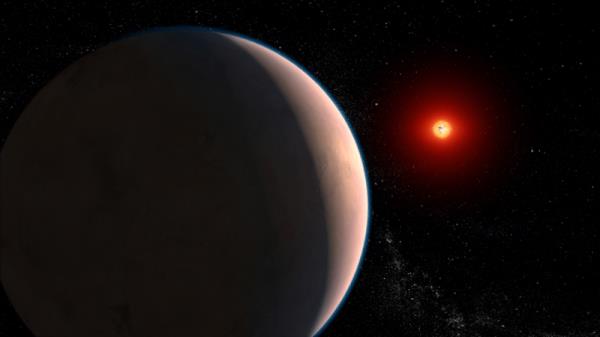

人工智能通过悬停在大量文本(通常是从互联网上抓取的网站)上,并找到单词之间的统计关系(文件图像)来学习“说话”。

人工智能如何学习

没有数据,人工智能软件什么都不是。

这些工具通过机器学习开发智能,这一过程允许计算机自己“学习”,而不需要程序员告诉它们每一步。给计算机输入大量数据,它最终可以识别模式并预测结果。

这个过程的关键是神经网络,这是一个像计算机化的大脑一样运作的数学系统,帮助技术在数据中找到联系。

它们以人脑为模型,有一层又一层的人工“神经元”,可以相互交流信息。即使是专家也不一定了解神经网络工作的所有复杂性。

大型语言模型(Large language models,简称llm)是一种神经网络,它可以学习写作并与用户交谈;他们支持最近几个月突然出现的所有聊天机器人。

他们通过悬浮在大量的文本(通常是从互联网上抓取的网站)上,并找到单词之间的统计关系来学习“说话”。

当这些系统模式匹配时,它可以带来创造力的奇迹:聊天机器人可以创作出与Jay-Z风格非常匹配的歌词,因为它吸收了他整个专辑的模式。但是法学硕士不知道单词背后的意思。

参数是大型语言模型训练数据中的数字点,它决定了它在任务上的熟练程度,比如预测句子中的下一个单词。

一些研究人员表示,在未来,这项技术将接近人工通用智能(AGI),达到与人类智力相当或超过人类智力的程度。

这个想法是一些人工智能实验室的核心使命,比如OpenAI,它在成立文件中将实现AGI列为目标。其他专家认为,人工智能离实现这种复杂程度还差得远,一些批评者认为这是一个营销术语。

我们如何与人工智能互动?

人们体验人工智能最常见的方式是通过聊天机器人,它就像一种高级形式的即时通讯工具,回答问题并根据提示制定任务。

这些机器人是根据大量的互联网数据进行训练的,包括Reddit上的对话和电子书。专家说,聊天机器人在寻找模式和模仿语音方面非常熟练,但它们不解释意思。

“这是一个超级、超高保真的自动补全版本,”伯恩鲍姆在谈到为聊天机器人提供动力的法学硕士时表示。

自去年11月推出以来,ChatGPT以其流畅的语言生成能力震惊了用户——生成完整的小说、计算机代码、电视剧集和歌曲。GPT代表“生成预训练变压器”。

“生成”意味着它使用人工智能来创造东西。“预训练”意味着它已经在大量数据上进行了训练。“转换器”是一种强大的神经网络,可以处理语言。

由旧金山初创公司OpenAI创建的ChatGPT已经导致许多公司纷纷发布自己的聊天机器人。微软的聊天机器人Bing使用了与ChatGPT相同的底层技术。谷歌发布了一个聊天机器人,巴德,基于该公司的LaMDA模型。

一些人认为聊天机器人将改变人们在互联网上查找和消费信息的方式。人们不需要在谷歌等搜索引擎中输入一个词,然后在各种链接中筛选,而是向聊天机器人提问,然后得到一个自信的回答。(虽然有时这些答案是错误的,但请继续关注!)

驯服AI:深度造假、幻觉和错误信息

生成式人工智能的蓬勃发展带来了令人兴奋的可能性,但也令人担忧尖端技术可能会造成危害。

聊天机器人有时会编造消息来源或自信地传播错误信息。在一个案例中,ChatGPT捏造了针对一名大学法学教授的性骚扰丑闻。它也可以炮制阴谋论和种族主义的答案。

有时它会在工作中表现出偏见:在一项实验中,当被要求寻找“罪犯”时,机器人会识别出黑人男性,并将所有“家庭主妇”标记为女性。

人工智能伦理学家和研究人员长期以来一直担心,因为聊天机器人利用了大量的人类语言——使用了从Twitter到维基百科的数据——它们吸收了我们的问题和偏见。公司试图设置语义护栏来限制聊天机器人能说什么,但这并不总是有效。

有时,人工智能产生的信息听起来似乎可信,但实际上是无关的、荒谬的或完全错误的。这些奇怪的弯路被称为幻觉。

还有一些人沉迷于聊天机器人,他们错误地认为聊天机器人是有知觉的,这意味着它可以在人类控制之外思考、感觉和行动。专家说,它不能——至少现在还不能——但它可以用流畅的方式说话,这样它就能模仿一些有生命的东西。

另一个担忧是深度造假,这是一种合成的照片、音频或视频,看起来是假的,但看起来是真的。同样的技术可以产生令人敬畏的图像,也可以用来伪造战争,让名人说出他们实际上没有说过的话,并可能造成大规模的混乱或伤害。

公司测试他们的人工智能模型的漏洞,通过模拟一个被称为红队的过程中的缺陷来消除偏见和弱点。

尽管人们试图驯服这项技术,但生成式人工智能的创新和复杂性还是让一些人感到担忧。

佐治亚理工学院(Georgia Tech)计算机学教授、机器学习专家马克·里德尔(Mark Riedl)说,“当事物像人类一样与我们交谈时,我们会感到有点难以置信。”

“我们有点假设这些东西试图忠实于我们,当它们被认为是权威的时候,我们很难怀疑。”

由生成式人工智能支持的聊天机器人可以进行令人毛骨悚然的逼真对话(资料图)。

参与聊天机器人竞赛的公司

OpenAI:这家总部位于旧金山的人工智能研究实验室是一家非营利组织,旨在打造不受大型科技公司控制的“通用人工智能”。

从那以后,它转变为一个主要的企业参与者,创造了图像生成器DALL-E,聊天机器人ChatGPT。它现在是营利性的,并与微软和Salesforce等公司合作。

b谷歌:这家科技巨头——长期以来在人工智能领域(包括通过搜索)处于领先地位——在竞争对手的产品走红后推出了聊天机器人巴德。它以其LaMDA技术而闻名,这是一种基于大型语言模型构建聊天机器人的系统。

微软:这家软件公司向OpenAI投资了数十亿美元,并合作开发了基于GPT-4技术的必应聊天机器人。但也有一些失误,包括聊天机器人失控,告诉记者它有感情,并称自己为悉尼——迫使这家科技巨头在某些方面收回了它。

meta:甚至在ChatGPT之前,Facebook的母公司就发布了一款名为Blenderbot的聊天机器人,但未能获得关注。该公司首席人工智能科学家后来称该机器人“无聊”,因为它“安全”。

IBM: IBM是人工智能领域的早期领导者,与当前的聊天机器人趋势接近,最著名的是它的机器人沃森,它在Jeopardy!